Il Linguaggio di Programmazione Rust

di Steve Klabnik, Carol Nichols, and Chris Krycho, con contributi della Community Rust

Questa versione del testo presuppone l’utilizzo di Rust 1.90.0 (rilasciato il

2025-09-18) o successivo con edition = "2024" nel file Cargo.toml di tutti i

progetti per configurarli in modo da utilizzare gli idiomi dell’edizione 2024 di

Rust. Consulta la sezione “Installazione” del Capitolo 1 per installare o aggiornare Rust, e vedi l’Appendice E per informazioni sulle varie edizioni.

Il libro originale in inglese in formato HTML si trova su

https://doc.rust-lang.org/stable/book/

oppure offline su installazioni di Rust fatte tramite rustup; esegui rustup doc --book per visualizzarlo.

Sono disponibili alcune traduzioni fatte dalla community.

Questo testo, in inglese, è disponibile anche come libro cartaceo o ebook da No Starch Press.

🚨 Vuoi provare un’esperienza di apprendimento più interattiva? Prova una versione modificata del Libro (in inglese), con aggiunta di quiz, sottolineature, visualizzazioni e molto altro: https://rust-book.cs.brown.edu

Prefazione

Il linguaggio di programmazione Rust ha fatto molta strada in pochi anni, dalla sua creazione e incubazione da parte di una piccola e giovane comunità di appassionati, fino a diventare uno dei linguaggi di programmazione più amati e richiesti al mondo. Ripensando a tutto ciò, era inevitabile che la potenza e le promesse di Rust attirassero l’attenzione e trovassero spazio nella programmazione di sistemi. Quello che non era scontato era la crescita globale dell’interesse e dell’innovazione che ha permeato le comunità open source, catalizzando un’adozione su larga scala in vari settori.

Oggi è facile indicare le meravigliose caratteristiche che Rust offre per spiegare questa esplosione di interesse e adozione. Chi non vorrebbe sicurezza nella gestione della memoria, e prestazioni elevate, e un compilatore amichevole, e ottimi strumenti, insieme a tante altre fantastiche funzionalità? Il linguaggio Rust che vedi oggi combina anni di ricerca nella programmazione di sistemi con la saggezza pratica di una comunità vivace e appassionata. Questo linguaggio è stato progettato con uno scopo e realizzato con cura, offrendo agli sviluppatori uno strumento che rende più facile scrivere codice sicuro, veloce e affidabile.

Ma ciò che rende Rust davvero speciale sono le sue radici nel dare potere a te, l’utente, per raggiungere i tuoi obiettivi. Questo è un linguaggio che vuole che tu abbia successo, e il principio di empowerment attraversa il cuore della comunità che costruisce, mantiene e promuove questo linguaggio. Dall’edizione precedente di questo testo definitivo, Rust si è ulteriormente sviluppato in un linguaggio davvero globale e affidabile. Il Rust Project è ora robustamente supportato dalla Rust Foundation, che investe anche in iniziative chiave per garantire che Rust sia sicuro, stabile e sostenibile.

Questa edizione di The Rust Programming Language è un aggiornamento completo, che riflette l’evoluzione del linguaggio nel corso degli anni e fornisce nuove informazioni preziose. Ma non è solo una guida alla sintassi e alle librerie: è un invito a unirti a una comunità che valorizza qualità, prestazioni e design riflessivo. Che tu sia uno sviluppatore esperto che vuole esplorare Rust per la prima volta o un Rustacean esperto che cerca di affinare le proprie abilità, questa edizione offre qualcosa per tutti.

Il viaggio di Rust è stato caratterizzato da collaborazione, apprendimento e iterazione. La crescita del linguaggio e del suo ecosistema è un riflesso diretto della comunità vibrante e diversificata che lo sostiene. I contributi di migliaia di sviluppatori, dai progettisti del linguaggio ai collaboratori occasionali, sono ciò che rende Rust uno strumento così unico e potente. Prendendo in mano questo libro, non stai solo imparando un nuovo linguaggio di programmazione: stai entrando a far parte di un movimento per rendere il software migliore, più sicuro e più piacevole da usare.

Benvenuto nella comunità di Rust!

- Bec Rumbul, Direttore Esecutivo della Rust Foundation

Introduzione

Nota: questa edizione del libro in inglese è identica a The Rust Programming Language, disponibile in formato cartaceo ed ebook presso No Starch Press.

Benvenuti a Il Linguaggio di Programmazione Rust, un libro introduttivo su Rust. Il linguaggio di programmazione Rust ti aiuta a scrivere software più veloce e affidabile. L’ergonomia di alto livello e il controllo di basso livello sono spesso in contrasto nella progettazione dei linguaggi di programmazione; Rust sfida questo conflitto. Grazie al bilanciamento tra potenti capacità tecniche e un’ottima esperienza di sviluppo, Rust ti offre la possibilità di controllare i dettagli di basso livello (come l’utilizzo della memoria) senza tutte le difficoltà tradizionalmente associate a tale controllo.

A Chi È Rivolto Rust

Rust è ideale per molte persone per una serie di motivi. Diamo un’occhiata ad alcuni dei gruppi più importanti.

Team di Sviluppatori

Rust si sta dimostrando uno strumento produttivo per la collaborazione tra grandi team di sviluppatori con diversi livelli di conoscenza della programmazione di sistemi. Il codice di basso livello è soggetto a vari bug subdoli, che nella maggior parte degli altri linguaggi possono essere individuati solo attraverso test approfonditi e un’attenta revisione del codice da parte di sviluppatori esperti. In Rust, il compilatore svolge un ruolo di gatekeeper rifiutando di compilare il codice con questi bug subdoli, compresi i bug di concorrenza. Lavorando a fianco del compilatore, il team può dedicare il proprio tempo a concentrarsi sulla logica del programma piuttosto che a cercare i bug.

Rust porta anche strumenti di sviluppo contemporanei nel mondo della programmazione di sistemi:

- Cargo, il gestore di dipendenze e strumento di compilazione integrato, rende l’aggiunta, la compilazione e la gestione delle dipendenze semplice e coerente in tutto l’ecosistema Rust.

- Lo strumento di formattazione

rustfmtgarantisce uno stile di programmazione coerente tra gli sviluppatori. - Il Server LSP del Linguaggio Rust potenzia l’integrazione dell’ambiente di sviluppo integrato (IDE) per il completamento del codice e i messaggi di errore in linea.

Utilizzando questi e altri strumenti dell’ecosistema Rust, gli sviluppatori possono essere produttivi mentre scrivono codice a livello di sistema.

Studenti

Rust è rivolto agli studenti e a coloro che sono interessati a conoscere i concetti di sistema. Utilizzando Rust, molte persone hanno imparato a conoscere argomenti come lo sviluppo di sistemi operativi. La comunità è molto accogliente e felice di rispondere alle domande degli studenti. Attraverso iniziative come questo libro, i team di Rust vogliono rendere i concetti di sistema più accessibili a un maggior numero di persone, soprattutto a chi è alle prime armi con la programmazione.

Aziende

Centinaia di aziende, grandi e piccole, utilizzano Rust in produzione per una serie di compiti, come strumenti a riga di comando, servizi web, strumenti DevOps, dispositivi embedded, analisi e transcodifica di audio e video, cripto-valute, bioinformatica, motori di ricerca, applicazioni per l’Internet delle cose, machine learning e persino parti importanti del browser web Firefox.

Sviluppatori Open Source

Rust è per le persone che vogliono costruire il linguaggio di programmazione Rust, la comunità, gli strumenti per gli sviluppatori e le librerie. Ci piacerebbe che tu contribuissi al linguaggio Rust.

Persone che Apprezzano la Velocità e la Stabilità

Rust è per le persone che desiderano velocità e stabilità in un linguaggio. Per velocità intendiamo sia la velocità con cui il codice Rust può essere eseguito, sia la velocità con cui Rust ti permette di scrivere programmi. I controlli del compilatore di Rust assicurano la stabilità quando si aggiungono funzionalità e riscrive il codice, in contrasto con la fragilità del codice legacy dei linguaggi senza questi controlli, che spesso gli sviluppatori hanno paura di modificare. Puntando ad astrazioni a costo zero, ovvero funzionalità di livello superiore che vengono compilate in codice di livello inferiore con la stessa velocità del codice scritto manualmente, Rust cerca di rendere il codice sia sicuro che veloce.

Il linguaggio Rust spera di supportare anche molti altri utenti; quelli citati qui sono solo alcuni dei maggiori interessati. Nel complesso, la più grande ambizione di Rust è quella di eliminare i compromessi che i programmatori hanno accettato per decenni, offrendo sicurezza e produttività, velocità e ergonomia. Prova Rust e vedi se le sue scelte funzionano per te.

Per Chi È Questo Libro

Questo libro presuppone che tu abbia scritto codice in un altro linguaggio di programmazione, ma non fa alcuna ipotesi su quale sia. Abbiamo cercato di rendere il materiale ampiamente accessibile a coloro che provengono da un’ampia varietà di background di programmazione. Non dedichiamo molto tempo a parlare di cosa sia la programmazione o di come pensarla. Se sei completamente nuovo alla programmazione, è meglio che tu legga un libro che fornisca un’introduzione specifica alla programmazione.

Come Utilizzare Questo Libro

In generale, questo libro presuppone che tu lo legga in sequenza, dall’inizio alla fine. I capitoli più avanzati si basano sui concetti dei capitoli precedenti, e i capitoli iniziali potrebbero non approfondire un determinato argomento, che invece viene sviluppato più approfonditamente in un capitolo successivo.

In questo libro troverai due tipi di capitoli: i capitoli concettuali e i capitoli di progetto. Nei capitoli concettuali, imparerai a conoscere un aspetto di Rust. Nei capitoli di progetto, costruiremo insieme dei piccoli programmi, applicando ciò che hai imparato finora. I capitoli 2, 12 e 21 sono capitoli di progetto; il resto sono capitoli concettuali.

Il Capitolo 1 spiega come installare Rust, come scrivere un programma “Hello, world!” e come utilizzare Cargo, il gestore di pacchetti e lo strumento di compilazione di Rust. Il Capitolo 2 è un’introduzione pratica alla scrittura di un programma in Rust, con la creazione di un gioco di indovinelli con i numeri. Qui trattiamo i concetti ad un livello più superficiale e i capitoli successivi forniranno ulteriori dettagli. Se vuoi sporcarti subito le mani, il Capitolo 2 è dove puoi iniziare. Se invece sei uno studente particolarmente meticoloso, che preferisce imparare ogni dettaglio prima di passare al successivo, potresti voler saltare il Capitolo 2 e passare direttamente al Capitolo 3 che tratta le caratteristiche di Rust simili a quelle di altri linguaggi di programmazione; dopo, potrai ritornare al Capitolo 2 se vorrai applicare in un progetto quanto appreso.

Nel Capitolo 4 imparerai a conoscere il sistema di proprietà (ownership

d’ora in poi) di Rust. Il Capitolo 5 parla di strutture e metodi, mentre il

Capitolo 6 tratta le enumerazioni, le espressioni match e il costrutto

della struttura di controllo if let. Utilizzerai le strutture e le

enumerazioni per creare type personalizzati in Rust.

Nel Capitolo 7 imparerai a conoscere il sistema dei moduli di Rust, le regole di visibilità per l’organizzazione del codice e la sua Application Programming Interface (API) pubblica. Il Capitolo 8 tratta alcune strutture di dati comuni che la libreria standard mette a disposizione, come vettori, stringhe e mappe hash. Il Capitolo 9 esplora la filosofia e le tecniche di gestione degli errori di Rust.

Il Capitolo 10 approfondisce i generici, i tratti e la longevità (trait e

lifetime), che ti danno la possibilità di definire codice applicabile a più

tipologie di dato. Il Capitolo 11 è dedicato ai test, che anche con le

garanzie di sicurezza di Rust sono necessari per garantire la correttezza della

logica del tuo programma. Nel Capitolo 12, costruiremo la nostra

implementazione di un sottoinsieme di funzionalità dello strumento da riga di

comando grep, che cerca il testo all’interno dei file. Per questo,

utilizzeremo molti dei concetti discussi nei capitoli precedenti.

Il Capitolo 13 esplora le chiusure e gli iteratori: caratteristiche di Rust che derivano dai linguaggi di programmazione funzionale. Nel Capitolo 14 esamineremo Cargo in modo più approfondito e parleremo delle migliori pratiche per condividere le tue librerie con altri. Il Capitolo 15 parla dei puntatori intelligenti che la libreria standard mette a disposizione e dei traits che ne consentono la funzionalità.

Nel Capitolo 16, esamineremo diversi modelli di programmazione concorrente e parleremo di come Rust ti aiuti a programmare con più sotto-processi (thread d’ora in poi) senza paura. Nel Capitolo 17, esploreremo la sintassi async e await di Rust, insieme a task, futures e stream, e il modello di concomitanza leggera che consentono.

Il Capitolo 18 analizza come gli idiomi di Rust si confrontano con i principi della programmazione orientata agli oggetti che potresti conoscere. Il Capitolo 19 è un riferimento ai pattern e al loro riconoscimento (pattern matching), che sono modi potenti di esprimere idee nei programmi Rust. Il Capitolo 20 contiene una varietà di argomenti di interesse, tra cui Rust non sicuro (unsafe Rust d’ora in poi), macro e altre informazioni su longevità, trait, tipologie (type), funzioni e chiusure.

Nel Capitolo 21, completeremo un progetto in cui implementeremo un server web multi-thread di basso livello!

Infine, alcune appendici contengono informazioni utili sul linguaggio in un formato meno strutturato. L’Appendice A tratta delle parole chiave di Rust, l’Appendice B degli operatori e dei simboli di Rust, l’Appendice C dei trait derivabili forniti dalla libreria standard, l’Appendice D di alcuni utili strumenti di sviluppo e l’Appendice E delle varie edizioni di Rust. Nell’Appendice F puoi trovare un elenco delle traduzioni del libro, mentre nell’Appendice G si parlerà di come viene realizzato Rust e di cosa sia la nightly Rust.

Non c’è un modo sbagliato di leggere questo libro: se vuoi andare avanti, fallo pure! Potresti dover tornare indietro ai capitoli precedenti se ti senti confuso, ma fai quello che va bene per te.

Una parte importante del processo di apprendimento di Rust consiste nell’imparare a leggere i messaggi di errore visualizzati dal compilatore: questi ti guideranno verso un codice funzionante. Per questo motivo, ti forniremo molti esempi che non si compilano insieme al messaggio di errore che il compilatore ti mostrerà in ogni situazione. Sappi che se inserisci ed esegui un esempio a caso, potrebbe non compilarsi! Assicurati di leggere il testo circostante per capire se l’esempio che stai cercando di eseguire è destinato a dare un errore. Nella maggior parte delle situazioni, ti guideremo alla correzione di questi errori che comportano la mancata compilazione. Ferris ti aiuterà anche a distinguere il codice che non è destinato a funzionare:

| Ferris | Significato |

|---|---|

| Questo codice non si compila! | |

| Questo codice genera panic! | |

| Questo codice non funziona come dovrebbe. |

Nella maggior parte dei casi, ti guideremo alla versione corretta di qualsiasi codice che non si compila.

Codice Sorgente

I file sorgente da cui è stato generato questo libro si trovano su GitHub per la versione italiana.

La versione originale in inglese si trova anch’essa su GitHub.

Primi Passi

Iniziamo il tuo viaggio in Rust! C’è molto da imparare, ma ogni viaggio inizia da qualche parte. In questo capitolo parleremo di come:

- Installare Rust su Linux, macOS e Windows

- Scrivere un programma che stampi

Hello, world! - Utilizzare

cargo, il gestore di pacchetti e il sistema di compilazione di Rust

Installazione

Il primo passo è quello di installare Rust. Scaricheremo Rust attraverso

rustup, uno strumento a riga di comando per gestire le versioni di Rust e gli

strumenti associati. Per il download è necessaria una connessione a internet.

Nota: Se per qualche motivo preferisci non utilizzare

rustup, consulta la pagina Altri metodi di installazione di Rust per ulteriori opzioni.

I passaggi seguenti installano l’ultima versione stabile del compilatore Rust. Le garanzie di stabilità di Rust assicurano che tutti gli esempi del libro che vengono compilati continueranno a essere compilati anche con le versioni più recenti di Rust. L’output potrebbe differire leggermente da una versione all’altra perché Rust spesso migliora i messaggi di errore e gli avvertimenti. In altre parole, qualsiasi versione più recente e stabile di Rust che installerai utilizzando questi passaggi dovrebbe funzionare come previsto con il contenuto di questo libro.

Annotazioni per la Riga di Comando

In questo capitolo e in tutto il libro, mostreremo alcuni comandi utilizzati

nel terminale. Le linee che dovresti inserire in un terminale iniziano tutte

con $. Non è necessario digitare il carattere $; è il prompt della riga di

comando mostrato per indicare l’inizio di ogni comando. Le linee che non

iniziano con $ mostrano solitamente l’output del comando precedente.

Inoltre, gli esempi specifici per PowerShell useranno > anziché $.

Installare rustup su Linux o macOS

Se stai usando Linux o macOS, apri un terminale e inserisci il seguente comando:

$ curl --proto '=https' --tlsv1.2 https://sh.rustup.rs -sSf | sh

Il comando scarica uno script e avvia l’installazione dello strumento rustup,

che installa l’ultima versione stabile di Rust. Potrebbe esserti richiesta la

tua password. Se l’installazione ha successo, apparirà la seguente riga:

Rust is installed now. Great!

Avrai anche bisogno di un linker, che è un programma che Rust utilizza per unire i suoi output compilati in un unico file. È probabile che tu ne abbia già uno. Se ottieni errori di linker, dovresti installare un compilatore C, che di solito include un linker. Un compilatore C è utile anche perché alcuni pacchetti comuni di Rust dipendono dal codice C e avranno bisogno di un compilatore C.

Su macOS, puoi ottenere un compilatore C eseguendo:

$ xcode-select --install

Gli utenti Linux dovrebbero generalmente installare GCC o Clang, in base alla

documentazione della loro distribuzione. Ad esempio, se utilizzi Ubuntu, puoi

installare il pacchetto build-essential.

Installare rustup su Windows

Su Windows, vai su https://www.rust-lang.org/tools/install e segui le istruzioni per installare Rust. A un certo punto dell’installazione, ti verrà richiesto di installare Visual Studio, che fornisce un linker e le librerie native necessarie per compilare i programmi. Se hai bisogno di aiuto per questo passaggio, consulta https://rust-lang.github.io/rustup/installation/windows-msvc.html.

Il resto di questo libro utilizza comandi che funzionano sia in cmd.exe che in PowerShell. Se ci sono differenze specifiche, ti spiegheremo quale utilizzare.

Risolvere i Problemi

Per verificare se Rust è stato installato correttamente, apri il terminale e inserisci questo comando:

$ rustc --version

Dovresti vedere il numero di versione, l’hash del commit e la data del commit dell’ultima versione stabile rilasciata, nel seguente formato:

rustc x.y.z (abcabcabc yyyy-mm-dd)

Se vedi queste informazioni, hai installato Rust con successo! Se non vedi

queste informazioni, controlla che Rust sia nella tua variabile di sistema

%PATH% come segue.

Su Windows con CMD, usa:

> echo %PATH%

In PowerShell, usa:

> echo $env:Path

In Linux e macOS, usa:

$ echo $PATH

Se sembra essere tutto in ordine ma Rust non funziona ancora, ci sono diversi posti in cui puoi trovare aiuto. Scopri come metterti in contatto con altri Rustaceani (Rustacean d’ora in poi) (uno stupido soprannome con cui ci chiamiamo) sulla pagina della comunità.

Aggiornare e Disinstallare

Una volta che Rust è stato installato tramite rustup, l’aggiornamento a una

nuova versione è semplice. Dalla tua shell, esegui il seguente script di

aggiornamento:

$ rustup update

Per disinstallare Rust e rustup, esegui il seguente script di disinstallazione

dalla tua shell:

$ rustup self uninstall

Leggere la Documentazione in Locale

L’installazione di Rust include anche una copia locale della documentazione per

poterla leggere offline. Esegui rustup doc per aprire la documentazione locale

nel tuo browser.

Ogni qual volta hai un dubbio su un type o una funzione fornita dalla libreria standard e non sei sicuro di cosa faccia o di come usarla, usa la documentazione delle API per scoprirlo!

Usare Editor di Testo e IDE

Questo libro non fa alcuna ipotesi sugli strumenti che utilizzi per scrivere il codice Rust. Qualsiasi editor di testo è in grado di fare il suo lavoro! Tuttavia, molti editor di testo e IDE (ambienti di sviluppo integrati) hanno un supporto integrato per Rust. Puoi sempre trovare un elenco abbastanza aggiornato di molti editor e IDE nella pagina degli strumenti sul sito web di Rust.

Lavorare Offline con Questo Libro

In diversi esempi, utilizzeremo pacchetti Rust oltre alla libreria standard. Per

lavorare a questi esempi, dovrai disporre di una connessione a internet o aver

scaricato le dipendenze in anticipo. Per scaricare le dipendenze in anticipo,

puoi eseguire i seguenti comandi. (Spiegheremo cos’è cargo e cosa fa ciascuno

di questi comandi in dettaglio più avanti)

$ cargo new get-dependencies

$ cd get-dependencies

$ cargo add rand@0.8.5 trpl@0.2.0

In questo modo i download di questi pacchetti verranno memorizzati nella cache e

non sarà necessario scaricarli in seguito. Una volta eseguito questo comando,

non dovrai conservare la cartella get-dependencies. Se hai eseguito questo

comando, puoi aggiungere il flag --offline quando userai il comando cargo

nel resto del libro per utilizzare queste versioni memorizzate nella cache

invece di scaricarle da internet in quel momento.

Hello, World!

Ora che hai installato Rust, è il momento di scrivere il tuo primo programma

Rust. Quando si impara un nuovo linguaggio, è consuetudine scrivere un piccolo

programma che stampi sullo schermo il testo Hello, world!

Nota: questo libro presuppone una certa familiarità di base con la riga di comando. Rust non ha particolari esigenze per quanto riguarda l’editing o gli strumenti o dove risiede il tuo codice, quindi se preferisci usare IDE invece della riga di comando, sentiti libero di usare il tuo IDE preferito. Molti IDE ora hanno un certo grado di supporto per Rust; controlla la documentazione dell’IDE per maggiori dettagli. Il team di Rust si è concentrato sull’integrazione ottima con gli IDE tramite

rust-analyzer. Vedi Appendice D per maggiori dettagli.

Impostare una Directory dei Progetti

Inizierai creando una directory per memorizzare il tuo codice Rust. Per Rust non è importante dove si trovi il tuo codice, ma per gli esercizi e i progetti di questo libro ti consigliamo di creare una cartella progetti nella tua home directory e di tenere tutti i tuoi progetti lì.

Apri un terminale e inserisci i seguenti comandi per creare una cartella progetti e una cartella per il progetto “Hello, world!” all’interno della directory progetti.

Per Linux, macOS, e PowerShell su Windows, digita questo:

$ mkdir ~/progetti

$ cd ~/progetti

$ mkdir hello_world

$ cd hello_world

Per Windows con CMD, digita questo:

> mkdir "%USERPROFILE%\progetti"

> cd /d "%USERPROFILE%\progetti"

> mkdir hello_world

> cd hello_world

Programma Rust Basilare

Adesso crea un nuovo file sorgente e chiamalo main.rs. I file di Rust terminano sempre con l’estensione .rs. Se usi più di una parola nel nome del file, la convenzione è di usare un trattino basso per separarle. Ad esempio, usa hello_world.rs piuttosto che helloworld.rs.

Ora apri il file main.rs che hai appena creato e inserisci il codice del Listato 1-1.

fn main() { println!("Hello, world!"); }

Hello, world!Salva il file e torna alla finestra del terminale alla cartella ~/progetti/hello_world . Su Linux o macOS, inserisci i seguenti comandi per compilare ed eseguire il file:

$ rustc main.rs

$ ./main

Hello, world!

Su Windows, inserisci il comando .\main invece di ./main:

> rustc main.rs

> .\main

Hello, world!

Indipendentemente dal sistema operativo, la stringa Hello, world! dovrebbe

essere stampata sul terminale. Se non vedi questo output, consulta la sezione

“Risolvere i Problemi” nel capitolo

Installazione per trovare aiuto.

Se Hello, world! è stato stampato, congratulazioni! Hai ufficialmente scritto

un programma Rust. Questo ti rende un programmatore Rust, benvenuto!

Anatomia di un Programma Rust

Esaminiamo in dettaglio questo programma “Hello, world!”. Ecco il primo pezzo del puzzle:

fn main() { }

Queste righe definiscono una funzione chiamata main. La funzione main è

speciale: è sempre il primo codice che viene eseguito in ogni eseguibile Rust.

Qui, la prima riga dichiara una funzione chiamata main che non ha parametri e

non restituisce nulla. Se ci fossero dei parametri, andrebbero dentro le

parentesi (()).

Il corpo della funzione è racchiuso da {}. Rust richiede parentesi graffe

intorno a tutti i corpi delle funzioni. È buona norma posizionare la parentesi

graffa di apertura sulla stessa riga della dichiarazione della funzione,

aggiungendo uno spazio in mezzo.

Nota: se vuoi attenerti a uno stile standard in tutti i progetti Rust, puoi usare uno strumento di formattazione automatica chiamato

rustfmtper formattare il tuo codice in un particolare stile (maggiori informazioni surustfmtin Appendice D). Il team di Rust ha incluso questo strumento nella distribuzione standard di Rust, comerustc, quindi dovrebbe essere già installato sul tuo computer!

Il corpo della funzione main contiene il seguente codice:

#![allow(unused)] fn main() { println!("Hello, world!"); }

Questa riga fa tutto il lavoro di questo piccolo programma: stampa il testo sullo schermo. Ci sono tre dettagli importanti da notare.

Innanzitutto, println! chiama una macro di Rust. Se invece avesse chiamato

una funzione, sarebbe stata inserita come println (senza il !). Le macro di

Rust sono un modo per scrivere codice che genera codice per estendere la

sintassi di Rust e ne parleremo in modo più dettagliato nel Capitolo

20. Per ora, ti basterà sapere che usare una !

significa che stai chiamando una macro invece di una normale funzione e che le

macro non seguono sempre le stesse regole delle funzioni.

In secondo luogo, vedi la stringa "Hello, world!" che viene passata come

argomento a println! e la stringa viene stampata sullo schermo.

In terzo luogo, terminiamo la riga con un punto e virgola (;), che indica che

questa espressione è terminata e che la prossima è pronta per iniziare. La

maggior parte delle righe di codice Rust terminano con un punto e virgola

Compilare ed Eseguire

Hai appena eseguito un programma appena creato, quindi esaminiamo ogni fase del processo.

Prima di eseguire un programma Rust, devi compilarlo con il compilatore Rust

inserendo il comando rustc e passandogli il nome del tuo file sorgente, in

questo modo:

$ rustc main.rs

Se hai un background in C o C++, noterai che è simile a gcc o clang. Dopo

aver compilato con successo, Rust produce un eseguibile binario.

Su Linux, macOS e PowerShell su Windows, puoi vedere l’eseguibile usando il

comando ls nella tua shell:

$ ls

main main.rs

Su Linux e macOS, vedrai due file. Con PowerShell su Windows, vedrai gli stessi tre file che vedresti usando CMD. Con CMD su Windows, inserisci il seguente comando:

> dir /B %= the /B option says to only show the file names =%

main.exe

main.pdb

main.rs

Questo mostra il file del codice sorgente con estensione .rs, il file eseguibile (main.exe su Windows, solo main su tutte le altre piattaforme) e, se usi Windows, un file contenente informazioni di debug con estensione .pdb. Ora puoi eseguire il file main o main.exe, in questo modo:

$ ./main # or .\main su Windows

Se il tuo main.rs è il tuo programma “Hello, world!”, questa riga stampa

Hello, world! sul tuo terminale.

Se hai più familiarità con un linguaggio dinamico, come Ruby, Python o JavaScript, potresti non essere abituato alla compilazione e all’esecuzione di un programma come fasi separate. Rust è un linguaggio compilato in anticipo, il che significa che puoi compilare un programma e dare l’eseguibile a qualcun altro, che potrà eseguirlo anche senza avere Rust installato. Se dai a qualcuno un file .rb, .py o .js, deve avere un’implementazione di Ruby, Python o JavaScript installata (rispettivamente). Ma in questi linguaggi, hai bisogno di un solo comando per compilare ed eseguire il tuo programma. Sono compromessi diversi per ogni linguaggio di programmazione.

La semplice compilazione con rustc va bene per i programmi semplici, ma quando

il tuo progetto cresce, vorrai gestire tutte le opzioni e rendere facile la

condivisione del tuo codice. A seguire, ti presenteremo lo strumento Cargo, che

ti aiuterà a scrivere programmi Rust veri e propri.

Hello, Cargo!

Cargo è il sistema di compilazione e il gestore di pacchetti di Rust. La maggior parte dei Rustacean utilizza questo strumento per gestire i propri progetti Rust perché Cargo gestisce molte attività al posto tuo, come la compilazione del codice, il download delle librerie da cui dipende il tuo codice e la compilazione di tali librerie (chiamiamo le librerie di cui il tuo codice ha bisogno dipendenze)

I programmi Rust più semplici, come quello che abbiamo scritto finora, non hanno dipendenze. Se avessimo costruito il progetto “Hello, world!” con Cargo, questo avrebbe utilizzato solo la parte di Cargo che si occupa della costruzione del codice. Man mano che scriverai programmi Rust più complessi, aggiungerai delle dipendenze e se inizierai un progetto utilizzando Cargo, sarà molto più facile aggiungere dipendenze.

Poiché la stragrande maggioranza dei progetti Rust utilizza Cargo, il resto di questo libro presuppone che anche tu stia utilizzando Cargo. Cargo viene installato insieme a Rust se hai utilizzato l’installazione di cui si parla nella sezione “Installazione”. Se hai installato Rust in altro modo, controlla se Cargo è installato inserendo quanto segue nel tuo terminale:

$ cargo --version

Se viene visualizzato un numero di versione, allora è fatta! Se viene

visualizzato un errore, come ad esempio comando non trovato, consulta la

documentazione relativa al tuo metodo di installazione per determinare come

installare Cargo separatamente.

Creare un Progetto con Cargo

Creiamo un nuovo progetto utilizzando Cargo e vediamo come si differenzia dal nostro progetto originale “Hello, world!“. Torna alla tua cartella progetti (o dove hai deciso di memorizzare il tuo codice). Poi, su qualsiasi sistema operativo, esegui il seguente comando:

$ cargo new hello_cargo

$ cd hello_cargo

Il primo comando crea una nuova cartella e un nuovo progetto chiamato hello_cargo. Abbiamo chiamato il nostro progetto hello_cargo e Cargo crea i suoi file in una cartella con lo stesso nome.

Vai nella cartella hello_cargo ed elenca i file. Vedrai che Cargo ha generato due file e una cartella per noi: un file Cargo.toml e una cartella src con un file main.rs al suo interno.

Ha anche inizializzato un nuovo repository Git insieme a un file .gitignore. I

file Git non verranno generati se esegui cargo new all’interno di un

repository Git esistente; puoi annullare questo comportamento utilizzando cargo new --vcs=git.

Nota: Git è un diffuso software di controllo di versione distribuito. Puoi modificare

cargo newper utilizzare un altro sistema di controllo di versione o nessun sistema di controllo di versioni utilizzando il flag--vcs. Eseguicargo new --helpper vedere le opzioni disponibili.

Apri Cargo.toml nell’editor di testo che preferisci. Dovrebbe assomigliare al codice del Listato 1-2.

[package]

name = "hello_cargo"

version = "0.1.0"

edition = "2024"

[dependencies]

cargo newQuesto file è nel formato TOML (Tom’s Obvious, Minimal Language), che è il formato di configurazione di Cargo.

La prima riga, [package], è un’intestazione di sezione che indica che le

dichiarazioni seguenti stanno configurando un pacchetto. Man mano che

aggiungeremo altre informazioni a questo file, aggiungeremo altre sezioni.

Le tre righe successive definiscono le informazioni di configurazione di cui

Cargo ha bisogno per compilare il tuo programma: il nome, la versione e

l’edizione di Rust da utilizzare. Parleremo della chiave edition in Appendice

E.

L’ultima riga, [dependencies], è l’inizio di una sezione in cui puoi elencare

tutte le dipendenze del tuo progetto. In Rust, i pacchetti di codice sono

chiamati crates (inteso come cassetta, contenitore…). Non avremo bisogno di

altri crates per questo progetto, ma lo faremo nel primo progetto del Capitolo

2, quindi useremo questa sezione di dipendenze.

Ora apri src/main.rs e dai un’occhiata:

File: src/main.rs

fn main() { println!("Hello, world!"); }

Cargo ha generato per te un programma “Hello, world!”, proprio come quello che abbiamo scritto nel Listato 1-1! Finora, le differenze tra il nostro progetto e quello generato da Cargo sono che Cargo ha inserito il codice nella cartella src, e che c’è un file di configurazione Cargo.toml nella directory principale.

Cargo si aspetta che i tuoi file sorgente si trovino all’interno della cartella src. La directory principale del progetto è solo per i file README, le informazioni sulla licenza, i file di configurazione e tutto ciò che non riguarda il tuo codice. L’utilizzo di Cargo ti aiuta a organizzare i tuoi progetti: c’è un posto per ogni cosa e ogni cosa è al suo posto.

Se hai iniziato un progetto che non utilizza Cargo, come abbiamo fatto con il

progetto “Hello, world!”, puoi convertirlo in un progetto che utilizza Cargo.

Sposta il codice del progetto nella cartella src e crea un file Cargo.toml

appropriato. Un modo semplice per ottenere il file Cargo.toml è eseguire

cargo init, che lo creerà automaticamente.

Costruire e Eseguire un Progetto Cargo

Ora vediamo cosa cambia quando costruiamo ed eseguiamo il programma “Hello, world!” con Cargo! Dalla cartella hello_cargo, costruisci il tuo progetto inserendo il seguente comando:

$ cargo build

Compiling hello_cargo v0.1.0 (file:///progetti/hello_cargo)

Finished dev [unoptimized + debuginfo] target(s) in 2.85 secs

Questo comando crea un file eseguibile in target/debug/hello_cargo (o target\debug\hello_cargo.exe_ su Windows) anziché nella tua cartella corrente. Poiché la compilazione predefinita è una compilazione di debug, Cargo mette il binario in una cartella chiamata debug. Puoi eseguire l’eseguibile con questo comando:

$ ./target/debug/hello_cargo # o .\target\debug\hello_cargo.exe su Windows

Hello, world!

Se tutto è andato bene, Hello, world! dovrebbe essere stampato sul terminale.

L’esecuzione di cargo build per la prima volta fa sì che Cargo crei anche un

nuovo file nella directory principale: Cargo.lock. Questo file tiene traccia

delle versioni esatte delle dipendenze nel tuo progetto. Questo progetto non ha

dipendenze, quindi il file è un po’ scarno. Non dovrai mai modificare questo

file manualmente; Cargo gestisce il suo contenuto per te.

Abbiamo appena costruito un progetto con cargo build e lo abbiamo eseguito con

./target/debug/hello_cargo, ma possiamo anche usare cargo run per compilare

il codice e poi eseguire l’eseguibile risultante con un solo comando:

$ cargo run

Finished dev [unoptimized + debuginfo] target(s) in 0.0 secs

Running `target/debug/hello_cargo`

Hello, world!

Utilizzare cargo run è più comodo che doversi ricordare di eseguire cargo build e poi utilizzare l’intero percorso del binario, quindi la maggior parte

degli sviluppatori utilizza cargo run.

Nota che questa volta non abbiamo visto l’output che indicava che Cargo stava

compilando hello_cargo. Cargo ha capito che i file non erano cambiati, quindi

non ha ricostruito ma ha semplicemente eseguito il binario. Se avessi modificato

il codice sorgente, Cargo avrebbe ricostruito il progetto prima di eseguirlo e

avresti visto questo output:

$ cargo run

Compiling hello_cargo v0.1.0 (file:///progetti/hello_cargo)

Finished dev [unoptimized + debuginfo] target(s) in 0.33 secs

Running `target/debug/hello_cargo`

Hello, world!

Cargo offre anche un comando chiamato cargo check, che controlla rapidamente

il tuo codice per assicurarsi che venga compilato ma che non produce un

eseguibile:

$ cargo check

Checking hello_cargo v0.1.0 (file:///progetti/hello_cargo)

Finished dev [unoptimized + debuginfo] target(s) in 0.32 secs

E perché non dovresti volere un eseguibile? Spesso, cargo check è molto più

veloce di cargo build perché salta il passaggio della produzione di un

eseguibile. Se controlli continuamente il tuo lavoro mentre scrivi il codice,

l’uso di cargo check accelererà il processo di sapere se il tuo progetto è

privo di errori e compilabile! Per questo motivo, molti Rustacean eseguono

cargo check periodicamente mentre scrivono il loro programma per assicurarsi

che si compili. Poi eseguono cargo build quando sono pronti a creare

l’eseguibile.

Ricapitoliamo quello che abbiamo imparato finora su Cargo:

- Possiamo creare un progetto utilizzando

cargo new. - Possiamo costruire un progetto utilizzando

cargo build. - Possiamo costruire ed eseguire un progetto in un unico passaggio utilizzando

cargo run. - Possiamo costruire un progetto senza produrre un binario per controllare gli

errori utilizzando

cargo check. - Invece di salvare il risultato della compilazione nella stessa directory del nostro codice, Cargo lo salva nella directory target/debug.

Un ulteriore vantaggio dell’utilizzo di Cargo è che i comandi sono gli stessi indipendentemente dal sistema operativo su cui stai lavorando. Quindi, a questo punto, non forniremo più istruzioni specifiche per Linux e macOS rispetto a Windows.

Costruire per il Rilascio

Quando il tuo progetto è finalmente pronto per essere rilasciato, puoi usare

cargo build --release per compilarlo con le ottimizzazioni. Questo comando

creerà un eseguibile in target/release invece che in target/debug. Le

ottimizzazioni rendono il tuo codice Rust più veloce, ma attivarle allunga i

tempi di compilazione del tuo programma. Per questo motivo esistono due profili

diversi: uno per lo sviluppo, quando vuoi ricostruire rapidamente e spesso, e un

altro per la creazione del programma finale che darai a un utente e che non sarà

ricostruito più volte e che funzionerà il più velocemente possibile. Se vuoi

fare un benchmark del tempo di esecuzione del tuo codice, assicurati di eseguire

cargo build --release e di fare il benchmark con l’eseguibile in

target/release.

Sfruttare Le Convenzioni di Cargo

Con i progetti semplici, Cargo non offre molti vantaggi rispetto all’uso di

rustc, ma si dimostrerà utile quando i tuoi programmi diventeranno più

complessi. Quando i programmi diventano più file o hanno bisogno di una

dipendenza, è molto più facile lasciare che Cargo coordini la compilazione.

Anche se il progetto hello_cargo è semplice, ora utilizza gran parte degli

strumenti che userai nel resto della tua carriera in Rust. Infatti, per lavorare

su qualsiasi progetto esistente, puoi usare i seguenti comandi per verificare il

codice usando Git, passare alla directory del progetto e compilare:

$ git clone example.org/un_progetto_nuovo

$ cd un_progetto_nuovo

$ cargo build

Per maggiori informazioni su Cargo, consulta la documentazione.

Riepilogo

Sei già partito alla grande nel tuo viaggio assieme a Rust! In questo capitolo hai imparato a..:

- Installare l’ultima versione stabile di Rust usando

rustup. - Aggiornare a una versione più recente di Rust.

- Aprire la documentazione installata localmente.

- Scrivere ed eseguire un programma “Hello, world!” usando direttamente

rustc. - Creare ed eseguire un nuovo progetto usando le convenzioni di Cargo.

Questo è un ottimo momento per costruire un programma più sostanzioso per abituarsi a leggere e scrivere codice in Rust. Quindi, nel Capitolo 2, costruiremo un programma di gioco di indovinelli. Se invece preferisci iniziare imparando come funzionano in Rust alcuni concetti base della programmazione, consulta il Capitolo 3 e poi ritorna al Capitolo 2.

Programmare un Gioco di Indovinelli

Cominciamo a programmare in Rust lavorando insieme a un progetto pratico! Questo

capitolo ti introduce ad alcuni concetti comuni di Rust mostrandoti come

utilizzarli in un programma reale. Imparerai a conoscere let, match, metodi,

funzioni associate, crates esterni e molto altro ancora! Nei capitoli

successivi esploreremo queste idee in modo più dettagliato, mentre in questo

capitolo ti limiterai a mettere in pratica le nozioni fondamentali.

Implementeremo un classico problema di programmazione per principianti: un gioco di indovinelli. Ecco come funziona: il programma genererà un numero intero casuale compreso tra 1 e 100. Poi chiederà al giocatore di inserire un’ipotesi. Dopo aver inserito un’ipotesi, il programma indicherà se l’ipotesi è troppo bassa o troppo alta. Se l’ipotesi è corretta, il gioco stamperà un messaggio di congratulazioni e terminerà.

Impostare un Nuovo Progetto

Per creare un nuovo progetto, vai nella cartella progetti che hai creato nel Capitolo 1 e crea un nuovo progetto con Cargo, in questo modo:

$ cargo new gioco_indovinello

$ cd gioco_indovinello

Il primo comando, cargo new, prende il nome del progetto (gioco_indovinello)

come primo argomento. Il secondo comando entra nella directory del nuovo

progetto.

Diamo un’occhiata al file Cargo.toml appena generato:

File: Cargo.toml

[package]

name = "gioco_indovinello"

version = "0.1.0"

edition = "2024"

[dependencies]

Come hai visto nel Capitolo 1, cargo new genera per te un programma “Hello,

world!”. Guarda il file src/main.rs:

File: src/main.rs

fn main() { println!("Hello, world!"); }

Ora compiliamo questo programma “Hello, world!” ed eseguiamolo nello stesso

passaggio utilizzando il comando cargo run:

$ cargo run

Compiling gioco_indovinello v0.1.0 (file:///progetti/gioco_indovinello)

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.33s

Running `target/debug/gioco_indovinello`

Hello, world!

Il comando run è utile quando hai bisogno di iterare rapidamente su un

progetto, come faremo in questo gioco, testando velocemente ogni modifica prima

di passare alla successiva.

Riapri il file src/main.rs. In questo file scriverai tutto il codice.

Elaborare un’Ipotesi

La prima parte del programma del gioco di indovinelli richiederà l’input dell’utente, lo elaborerà e verificherà che l’input sia nella forma prevista. Per iniziare, permetteremo al giocatore di inserire un’ipotesi. Inserisci il codice del Listato 2-1 in src/main.rs.

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Questo codice contiene molte informazioni, quindi analizziamolo riga per riga.

Per ottenere l’input dell’utente e poi stampare il risultato come output,

dobbiamo utilizzare il modulo di input/output io. Il modulo io proviene

dalla libreria standard, nota come std:

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Come impostazione predefinita, Rust ha un insieme di risorse definite nella libreria standard che vengono inserite in ogni programma. Questo insieme è chiamato preludio (prelude d’ora in poi) e puoi vedere tutto ciò che contiene nella documentazione della libreria standard.

Se una risorsa che vuoi utilizzare non è presente nel prelude, devi renderla

disponibile esplicitamente con un’istruzione use. L’utilizzo del modulo

std::io ti offre una serie di utili funzioni, tra cui la possibilità di

ricevere input dall’utente.

Come hai visto nel Capitolo 1, la funzione main è il punto di ingresso del

programma:

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}La sintassi fn dichiara una nuova funzione; le parentesi, (), indicano che

non ci sono parametri; e la parentesi graffa, {, inizia il corpo della

funzione.

Come hai imparato nel Capitolo 1, println! è una macro che stampa una

stringa sullo schermo:

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Questo codice stampa un messaggio che introduce il gioco e richiede un input da parte dell’utente.

Memorizzare i Valori con le Variabili

Successivamente, creeremo una variabile per memorizzare l’input dell’utente, in questo modo:

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Ora il programma si fa interessante! In questa piccola riga succedono molte

cose. Usiamo l’istruzione let per creare la variabile. Ecco un altro esempio:

let mele = 5;Questa riga crea una nuova variabile di nome mele e la lega al valore 5. In

Rust, le variabili sono immutabili (immutable) come impostazione predefinita,

il che significa che una volta assegnato un valore alla variabile, il valore non

cambierà. Parleremo di questo concetto in dettaglio nella sezione “Variabili e

mutabilità” del Capitolo 3. Per

rendere mutabile (mutable) una variabile, aggiungiamo mut prima del nome

della variabile:

let mele = 5; // immutabile

let mut banane = 5; // mutabileNota: la sintassi

//inizia un commento che continua fino alla fine della riga. Rust ignora tutto ciò che è contenuto nei commenti. Parleremo dei commenti in modo più dettagliato nel Capitolo 3.

Torniamo al nostro gioco di indovinelli. Ora sai che let mut ipotesi

introdurrà una variabile mutabile di nome ipotesi. Il segno di uguale (=)

indica a Rust che vogliamo legare qualcosa alla variabile in quel momento. A

destra del segno di uguale c’è il valore a cui ipotesi è legata, che è il

risultato della chiamata a String::new, una funzione che restituisce una nuova

istanza di una String. String è un type di

stringa fornito dalla libreria standard che è un pezzo di testo codificato UTF-8

modificabile in lunghezza.

La sintassi :: nella riga ::new indica che new è una funzione associata al

type String. Una funzione associata è una funzione implementata su un

type, in questo caso String. Questa funzione new crea una nuova stringa

vuota. Troverai una funzione new in molti type perché è un nome comune per

una funzione che crea un nuovo valore di qualche tipo.

In pratica, la linea let mut ipotesi = String::new(); ha creato una variabile

mutable che è attualmente legata a una nuova istanza vuota di String. Wow!

Ricevere l’Input dell’Utente

Ricordiamo che abbiamo incluso le funzionalità di input/output della libreria

standard con use std::io; nella prima riga del programma. Ora chiameremo la

funzione stdin dal modulo io, che ci permetterà di gestire l’input

dell’utente:

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Se non avessimo importato il modulo io con use std::io; all’inizio del

programma, potremmo comunque utilizzare la funzione scrivendo questa chiamata di

funzione come std::io::stdin. La funzione stdin restituisce un’istanza di

std::io::Stdin, che è un type che rappresenta un

handle all’input standard del tuo terminale.

Successivamente, la riga .read_line(&mut ipotesi) chiama il metodo

read_line sull’handle di input standard per

ottenere un input dall’utente. Passiamo anche &mut ipotesi come argomento a

read_line per dirgli in quale stringa memorizzare l’input dell’utente. Il

compito di read_line è quello di prendere tutto ciò che l’utente digita

nell’input standard e aggiungerlo a una stringa (senza sovrascriverne il

contenuto), quindi passiamo tale stringa come argomento. L’argomento stringa

deve essere mutable in modo che il metodo possa cambiare il contenuto della

stringa.

Il simbolo & indica che questo argomento è un riferimento (reference d’ora

in poi), il che ti dà la possibilità di permettere a più parti del codice di

accedere a un dato senza doverlo copiare più volte in memoria. I reference

sono una funzionalità complessa e uno dei principali vantaggi di Rust è la

sicurezza e la facilità con cui è possibile utilizzarli. Non hai bisogno di

conoscere molti di questi dettagli per finire questo programma. Per ora, tutto

ciò che devi sapere è che, come le variabili, i reference sono immutabili come

impostazione predefinita. Di conseguenza, devi scrivere &mut ipotesi piuttosto

che solo &ipotesi per renderli mutable (il Capitolo 4 spiegherà i

reference in modo più approfondito)

Gestire i Potenziali Errori con Result

Stiamo ancora lavorando su questa riga di codice. Ora stiamo discutendo di una terza riga di testo, ma notiamo che fa ancora parte di un’unica riga logica di codice. La prossima parte è questo metodo:

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Avremmo potuto scrivere questo codice come:

io::stdin().read_line(&mut ipotesi).expect("Errore di lettura");Tuttavia, una riga lunga può essere difficile da leggere, quindi è meglio

dividerla. Spesso è consigliabile andare a capo e aggiungere degli spazi bianchi

per aiutare a spezzare le righe lunghe quando chiami un metodo con la sintassi

.nome_metodo(). Ora vediamo cosa fa questa riga.

Come accennato in precedenza, read_line inserisce qualsiasi cosa l’utente

inserisca nella stringa che gli passiamo, ma restituisce anche un valore

Result. Result è una enumerazione (enum per brevità), che è un type che può trovarsi in uno dei

molteplici stati possibili. Chiamiamo ogni stato possibile una variante.

Il Capitolo 6 tratterà le enum in modo più

dettagliato. Lo scopo di questi type Result è quello di fornire informazioni

sulla gestione degli errori.

Le varianti di Result sono Ok e Err. La variante Ok indica che

l’operazione è andata a buon fine e contiene il valore generato con successo. La

variante Err indica che l’operazione non è andata a buon fine e contiene

informazioni su come o perché l’operazione è fallita.

I valori del tipo Result, come i valori di qualsiasi type, hanno dei metodi

definiti su di essi. Un’istanza di Result ha un metodo expect che puoi chiamare. Se questa istanza di Result è un valore Err,

expect causerà l’arresto del programma e visualizzerà il messaggio che hai

passato come argomento a expect. Se il metodo read_line restituisce un

Err, è probabile che sia il risultato di un errore proveniente dal sistema

operativo sottostante. Se questa istanza di Result è un valore Ok, expect

prenderà il valore di ritorno che Ok sta tenendo e ti restituirà solo quel

valore in modo che tu possa usarlo. In questo caso, quel valore è il numero di

byte nell’input dell’utente.

Se non chiami expect, il programma verrà compilato, ma riceverai un avviso:

$ cargo build

Compiling gioco_indovinello v0.1.0 (file:///pregetti/gioco_indovinello)

warning: unused `Result` that must be used

--> src/main.rs:10:5

|

10 | io::stdin().read_line(&mut ipotesi);

| ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

|

= note: this `Result` may be an `Err` variant, which should be handled

= note: `#[warn(unused_must_use)]` on by default

help: use `let _ = ...` to ignore the resulting value

|

10 | let _ = io::stdin().read_line(&mut ipotesi);

| +++++++

warning: `gioco_indovinello` (bin "gioco_indovinello") generated 1 warning

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.29s

Rust avverte che non è stato utilizzato il valore Result restituito da

read_line, indicando che il programma non ha gestito un possibile errore.

Il modo corretto per sopprimere l’avvertimento è quello di scrivere del codice

che gestisca questi potenziali errori, ma nel nostro caso non è un grosso

problema mandare in crash il programma quando si verifica un problema, quindi

possiamo usare expect. Imparerai a recuperare dagli errori nel Capitolo

9.

Stampare i Valori con i Segnaposto in println!

A parte la parentesi graffa di chiusura, c’è un’ultima riga da discutere nel codice:

use std::io;

fn main() {

println!("Indovina il numero!");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Questa riga stampa la stringa che ora contiene l’input dell’utente. La serie di

parentesi graffe {} è un segnaposto: pensa a {} come a delle piccole chele

di granchio che tengono fermo un valore. Quando stampi il valore di una

variabile, il nome della variabile può essere inserito all’interno delle

parentesi graffe. Quando devi stampare il risultato della valutazione di

un’espressione, inserisci delle parentesi graffe vuote nella stringa di formato,

quindi fai seguire alla stringa di formato un elenco separato da virgole di

espressioni da stampare in ogni segnaposto vuoto, nello stesso ordine. Stampare

una variabile e il risultato di un’espressione in un’unica chiamata a println!

sarebbe così:

#![allow(unused)] fn main() { let x = 5; let y = 10; println!("x = {x} e y + 2 = {}", y + 2); }

Questo codice produrrà x = 5 e y + 2 = 12.

Proviamo la Prima Parte

Proviamo la prima parte del gioco di indovinelli utilizzando cargo run:

$ cargo run

Compiling gioco_indovinello v0.1.0 (file:///progetti/gioco_indovinello)

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.40s

Running `target/debug/gioco_indovinello`

Indovina il numero!

Inserisci la tua ipotesi.

6

Hai ipotizzato: 6

A questo punto, la prima parte del gioco è terminata: stiamo ricevendo input dalla tastiera e poi li stiamo stampando.

Generare un Numero Segreto

Ora dobbiamo generare un numero segreto che l’utente cercherà di indovinare. Il

numero segreto dovrebbe essere diverso ogni volta, in modo da rendere il gioco

divertente più di una volta. Utilizzeremo un numero casuale compreso tra 1 e

100, in modo che il gioco non sia troppo difficile. Rust non include ancora la

funzionalità dei numeri casuali nella sua libreria standard, ma il team di Rust

fornisce un crate rand con tale funzionalità.

Aumentare le Funzionalità con un Crate

Ricorda che un crate è una raccolta di file di codice sorgente in Rust. Il

progetto che stiamo costruendo è un crate binario, cioè un eseguibile. Il

crate rand è un crate libreria, che contiene codice destinato a essere

utilizzato in altri programmi e non può essere eseguito da solo.

Prima di poter scrivere del codice che utilizzi rand, dobbiamo modificare il

file Cargo.toml per includere il crate rand come dipendenza. Apri il file

e aggiungi la seguente riga in fondo, sotto l’intestazione della sezione delle

dipendenze [dependencies] che Cargo ha creato per te. Assicurati di

specificare rand esattamente come abbiamo fatto qui, con questo numero di

versione, altrimenti gli esempi di codice di questo tutorial potrebbero non

funzionare:

File: Cargo.toml

[dependencies]

rand = "0.8.5"

Nel file Cargo.toml, tutto ciò che segue un’intestazione fa parte di quella

sezione che continua fino all’inizio di un’altra sezione. In [dependencies],

indichi a Cargo quali sono i crate esterni da cui dipende il tuo progetto e

quali sono le versioni di tali crate richieste. In questo caso, specifichiamo

il crate rand con lo specificatore di versione semantica 0.8.5. Cargo

comprende il Versionamento Semantico (a volte chiamato

SemVer per brevità), che è uno standard per la scrittura dei numeri di

versione. Lo specificatore 0.8.5 è in realtà un’abbreviazione di ^0.8.5, che

indica qualsiasi versione che sia almeno 0.8.5 ma inferiore a 0.9.0.

Cargo considera queste versioni con API pubbliche compatibili con la versione 0.8.5 e questa specifica ti garantisce di ottenere l’ultima release della patch che si compila ancora con il codice di questo capitolo. Qualsiasi versione 0.9.0 o superiore non garantisce di avere le stesse API utilizzate negli esempi seguenti.

Ora, senza modificare alcun codice, costruiamo il progetto, come mostrato nel Listato 2-2.

$ cargo build

Updating crates.io index

Locking 15 packages to latest Rust 1.85.0 compatible versions

Adding rand v0.8.5 (available: v0.9.0)

Compiling proc-macro2 v1.0.93

Compiling unicode-ident v1.0.17

Compiling libc v0.2.170

Compiling cfg-if v1.0.0

Compiling byteorder v1.5.0

Compiling getrandom v0.2.15

Compiling rand_core v0.6.4

Compiling quote v1.0.38

Compiling syn v2.0.98

Compiling zerocopy-derive v0.7.35

Compiling zerocopy v0.7.35

Compiling ppv-lite86 v0.2.20

Compiling rand_chacha v0.3.1

Compiling rand v0.8.5

Compiling gioco_indovinello v0.1.0 (file:///progetti/gioco_indovinello)

Finished `dev` profile [unoptimized + debuginfo] target(s) in 2.48s

cargo build dopo l’aggiunta del crate rand come dipendenzaPotresti vedere numeri di versione diversi (ma saranno tutti compatibili con il codice, grazie a SemVer!) e righe diverse (a seconda del sistema operativo) e le righe potrebbero essere in un ordine diverso.

Quando includiamo una dipendenza esterna, Cargo recupera le ultime versioni di tutto ciò di cui la dipendenza ha bisogno dal registro, registry, che è una copia dei dati di Crates.io. Crates.io è il sito in cui le persone che fanno parte dell’ecosistema Rust pubblicano i loro progetti Rust open source che possono essere utilizzati da altri.

Dopo aver aggiornato il registro, Cargo controlla la sezione [dependencies] e

scarica tutti i crate elencati che non sono già stati scaricati. In questo

caso, anche se abbiamo elencato solo rand come dipendenza, Cargo ha preso

anche altri crate da cui rand dipende per funzionare. Dopo aver scaricato i

crate, Rust li compila e poi compila il progetto con le dipendenze

disponibili.

Se esegui immediatamente cargo build di nuovo senza apportare alcuna modifica,

non otterrai alcun risultato a parte la riga Finished. Cargo sa che ha già

scaricato e compilato le dipendenze e che non hai modificato nulla nel tuo file

Cargo.toml. Cargo sa anche che non hai modificato nulla del tuo codice, quindi

non ricompila nemmeno quello. Non avendo nulla da fare, semplicemente termina

l’esecuzione.

Se apri il file src/main.rs, apporti una modifica banale e poi salvi e ricostruisci, vedrai solo due righe di output:

$ cargo build

Compiling gioco_indovinello v0.1.0 (file:///progetti/gioco_indovinello)

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.13s

Queste righe mostrano che Cargo ricompila solo le modifiche, il file src/main.rs. Le dipendenze non sono cambiate, quindi Cargo sa di poter riutilizzare ciò che ha già scaricato e compilato in precedenza.

Garantire Build Riproducibili

Cargo ha un meccanismo che ti garantisce di ricostruire lo stesso artefatto ogni

volta che tu o chiunque altro costruisce il tuo codice: Cargo utilizzerà solo le

versioni delle dipendenze che hai specificato fino a quando non indicherai il

contrario. Per esempio, supponiamo che la prossima settimana esca la versione

0.8.6 del crate rand, che contiene un’importante correzione di un bug, ma

anche una regressione incompatibile con il tuo codice. Per gestire questo

problema, Rust crea il file Cargo.lock la prima volta che esegui cargo build, che quindi ora si trova nella directory gioco_indovinello.

Quando costruisci un progetto per la prima volta, Cargo calcola tutte le versioni delle dipendenze che soddisfano i criteri e le scrive nel file Cargo.lock. Quando costruisci il tuo progetto in futuro, Cargo vedrà che il file Cargo.lock esiste e userà le versioni specificate in esso, invece di fare tutto il lavoro per trovare di nuovo le versioni. In altre parole, il tuo progetto rimarrà alla versione 0.8.5 fino a quando non effettuerai un aggiornamento esplicito, grazie al file Cargo.lock. Poiché il file Cargo.lock è importante per la creazione di build riproducibili, spesso viene inserito nel controllo sorgente insieme al resto del codice del progetto.

Aggiornare un Crate per Ottenere una Nuova Versione

Quando vuoi aggiornare un crate, Cargo mette a disposizione il comando

update, che ignorerà il file Cargo.lock e troverà tutte le ultime versioni

che corrispondono alle tue specifiche in Cargo.toml. Cargo scriverà quindi

queste versioni nel file Cargo.lock. Altrimenti, di default, Cargo cercherà

solo le versioni maggiori di 0.8.5 e minori di 0.9.0. Se il crate rand ha

rilasciato nuove versioni sia per la versione 0.8 che per la 0.9, vedrai quanto

segue se eseguirai cargo update:

$ cargo update

Updating crates.io index

Locking 1 package to latest Rust 1.85.0 compatible version

Updating rand v0.8.5 -> v0.8.6 (available: v0.9.0)

Cargo ignora la versione 0.9.0. A questo punto, noterai anche un cambiamento nel

tuo file Cargo.lock che indica che la versione del crate rand che stai

utilizzando è la 0.8.6. Per utilizzare la versione 0.9.0 di rand o qualsiasi

altra versione della serie 0.9.x, dovrai aggiornare il file Cargo.toml in

questo modo:

[dependencies]

rand = "0.9.0"

La prossima volta che eseguirai cargo build, Cargo aggiornerà il registro dei

crate disponibili e rivaluterà i requisiti di rand in base alla nuova

versione che hai specificato.

C’è molto altro da dire su Cargo e sul suo ecosistema, di cui parleremo nel Capitolo 14, ma per ora questo è tutto ciò che devi sapere. Cargo rende molto facile il riutilizzo delle librerie, per cui i Rustacean sono in grado di scrivere progetti più piccoli che sono assemblati da una serie di pacchetti.

Generare un Numero Casuale

Iniziamo a usare rand per generare un numero da indovinare. Il passo

successivo è aggiornare src/main.rs, come mostrato nel Listato 2-3.

use std::io;

use rand::Rng;

fn main() {

println!("Indovina il numero!");

let numero_segreto = rand::thread_rng().gen_range(1..=100);

println!("Il numero segreto è: {numero_segreto}");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

}Per prima cosa aggiungiamo la riga use rand::Rng;. Il trait Rng definisce

i metodi che i generatori di numeri casuali implementano e questo trait deve

essere nell’ambito di utilizzo (in scope d’ora in poi), per poter utilizzare

tali metodi. Il Capitolo 10 tratterà in dettaglio i trait.

Nella prima riga, chiamiamo la funzione rand::thread_rng che ci fornisce il

particolare generatore di numeri casuali che utilizzeremo: un generatore locale

che si appoggia al sistema operativo. Poi chiamiamo il metodo gen_range sul

generatore di numeri casuali. Questo metodo è definito dal trait Rng che

abbiamo portato in scope con l’istruzione use rand::Rng;. Il metodo

gen_range prende un’espressione di intervallo come argomento e genera un

numero casuale nell’intervallo. Il tipo di espressione di intervallo che stiamo

usando qui ha la forma inizio..=fine ed è inclusivo dei limiti inferiore e

superiore, quindi dobbiamo specificare 1..=100 per richiedere un numero

compreso tra 1 e 100.

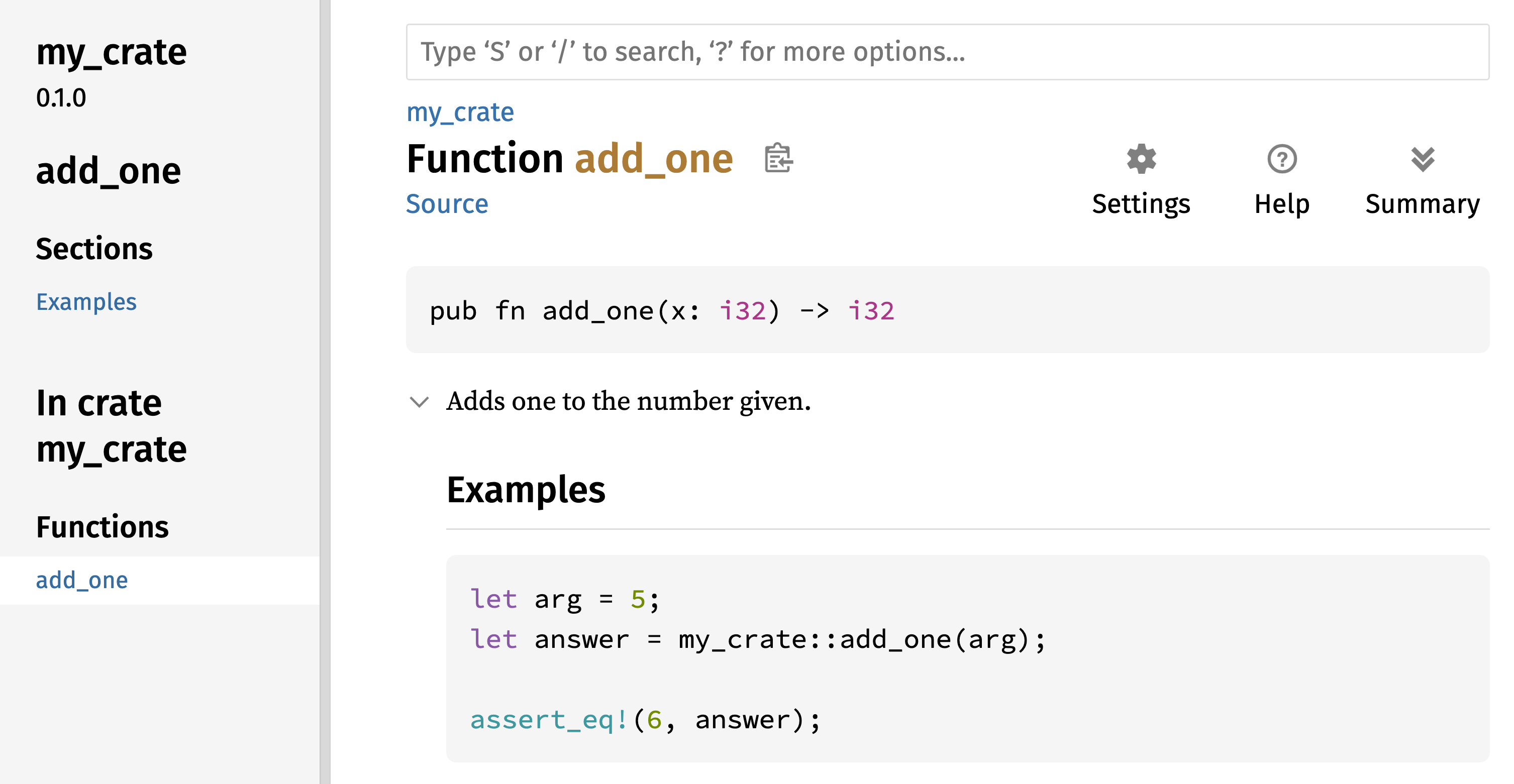

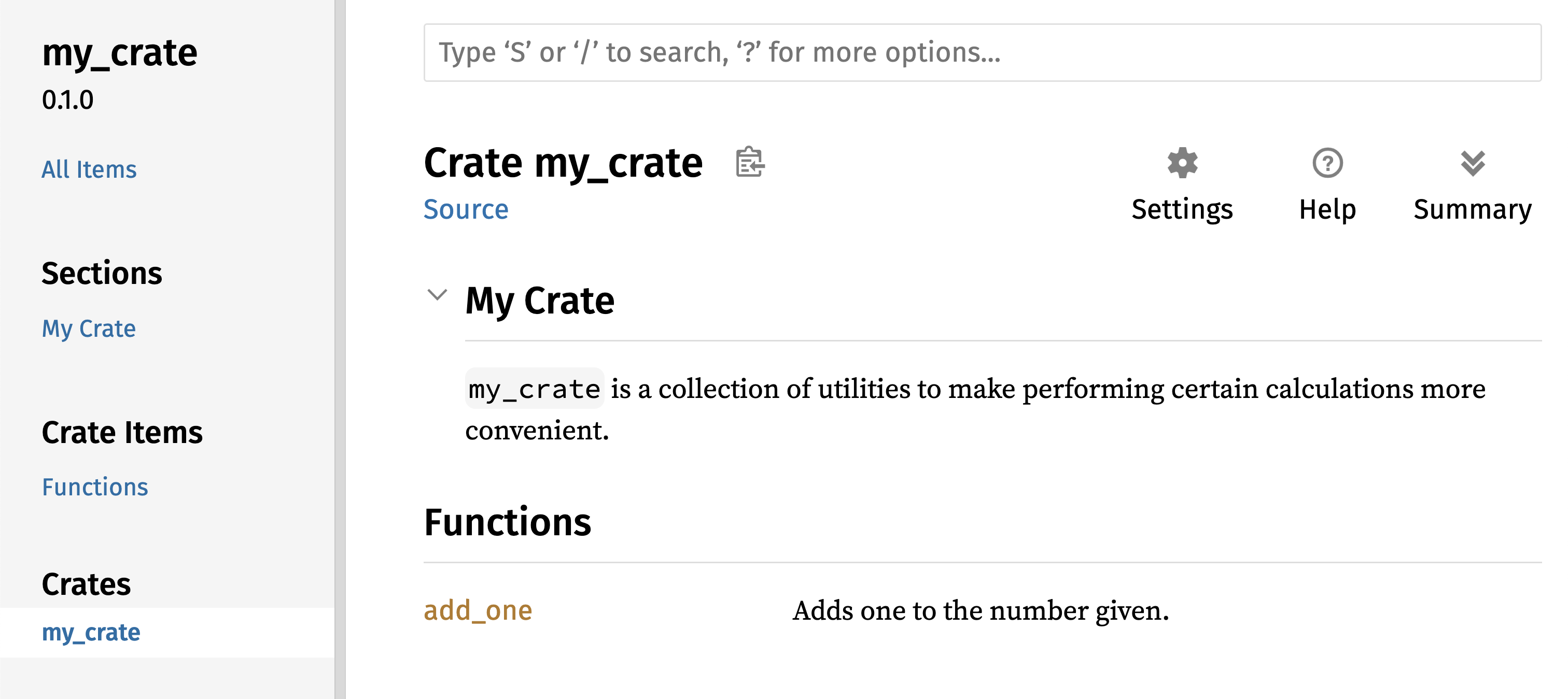

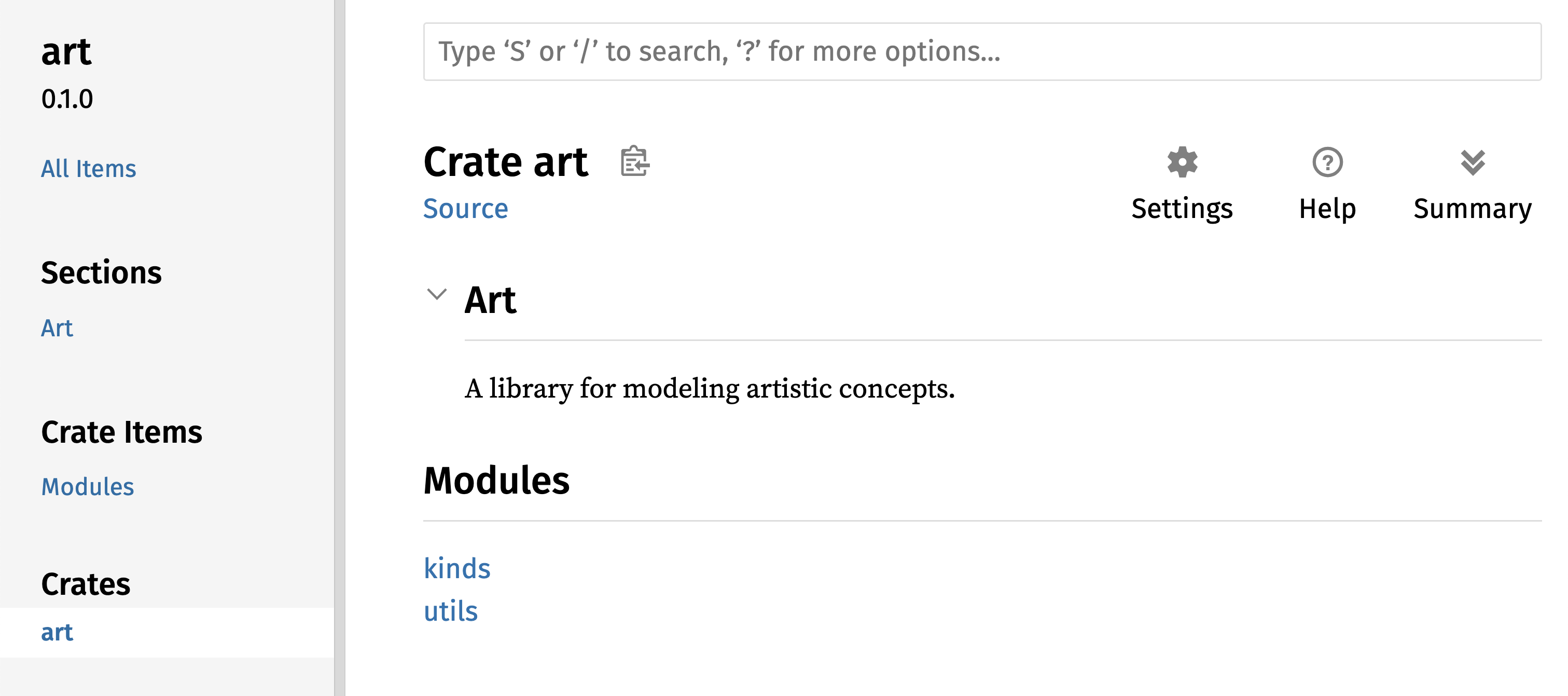

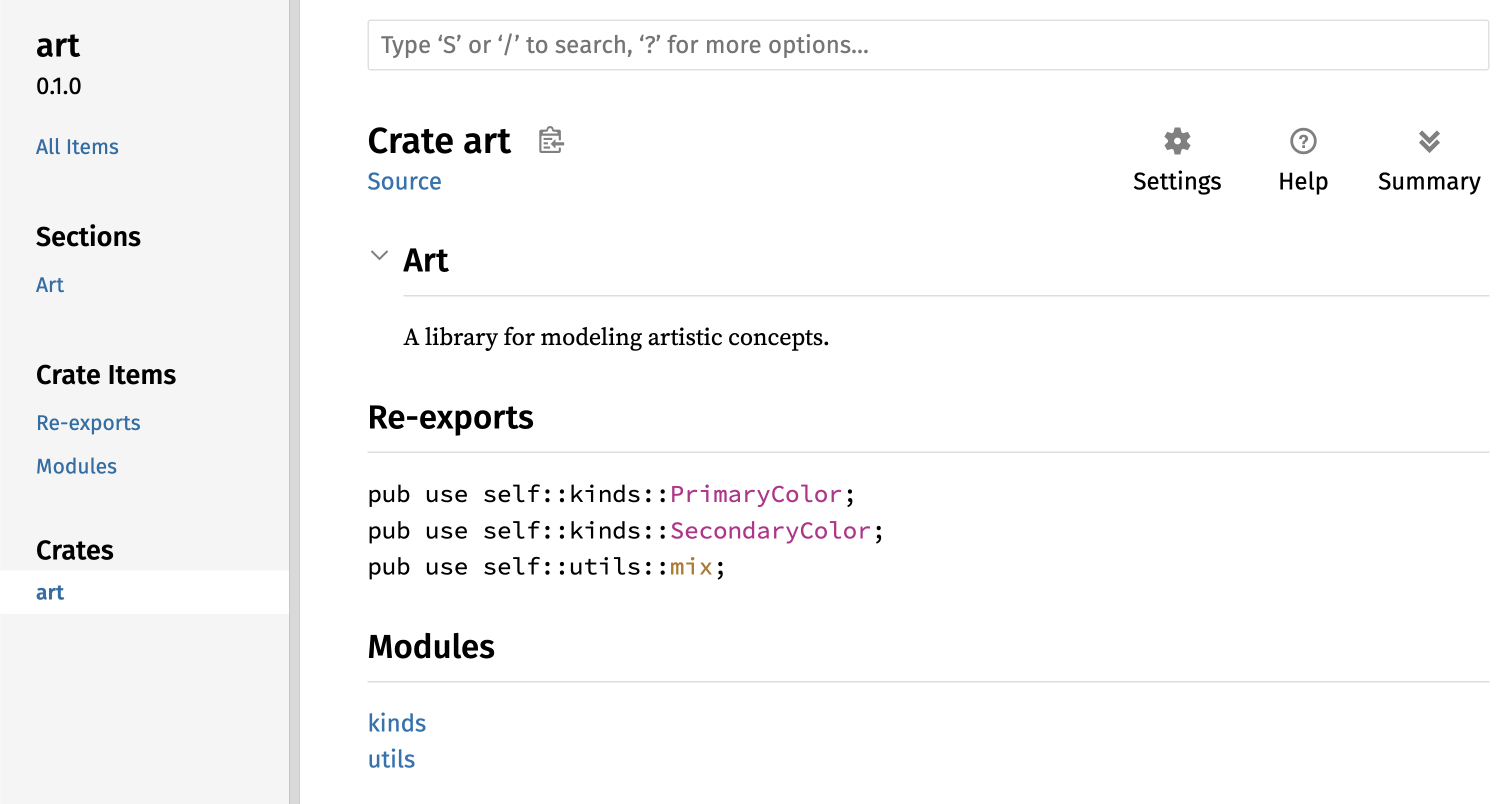

Nota: non sarai sempre a conoscenza di quali trait utilizzare e quali metodi e funzioni chiamare di un crate, quindi ogni crate ha una documentazione con le istruzioni per utilizzarlo. Un’altra caratteristica interessante di Cargo è che eseguendo il comando

cargo doc --open, la documentazione fornita da tutte le tue dipendenze viene creata localmente e aperta nel browser. Se sei interessato ad altre funzionalità del craterand, ad esempio, eseguicargo doc --opene clicca surandnella barra laterale a sinistra.

La seconda nuova riga stampa il numero segreto. Questo è utile durante lo sviluppo del programma per poterlo testare, ma lo elimineremo dalla versione finale. Non è un grande gioco se il programma stampa la risposta non appena inizia!

Prova a eseguire il programma alcune volte:

$ cargo run

Compiling gioco_indovinello v0.1.0 (file:///progetti/gioco_indovinello)

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.02s

Running `target/debug/gioco_indovinello`

Indovina il numero!

Il numero segreto è: 7

Inserisci la tua ipotesi.

4

Hai ipotizzato: 4

$ cargo run

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.02s

Running `target/debug/gioco_indovinello`

Indovina il numero!

Il numero segreto è: 83

Inserisci la tua ipotesi.

5

Hai ipotizzato: 5

Dovresti ottenere diversi numeri casuali, tutti compresi tra 1 e 100. Ottimo lavoro!

Confrontare l’Ipotesi con il Numero Segreto

Ora che abbiamo l’input dell’utente e un numero casuale, possiamo confrontarli. Questo passo è mostrato nel Listato 2-4. Nota che questo codice non è compilabile per il momento, come spiegheremo.

use std::cmp::Ordering;

use std::io;

use rand::Rng;

fn main() {

// --taglio--

println!("Indovina il numero!");

let numero_segreto = rand::thread_rng().gen_range(1..=100);

println!("Il numero segreto è: {numero_segreto}");

println!("Inserisci la tua ipotesi.");

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

println!("Hai ipotizzato: {ipotesi}");

match ipotesi.cmp(&numero_segreto) {

Ordering::Less => println!("Troppo piccolo!"),

Ordering::Greater => println!("Troppo grande!"),

Ordering::Equal => println!("Hai indovinato!"),

}

}Per prima cosa aggiungiamo un’altra istruzione use, che porta un type

chiamato std::cmp::Ordering dalla libreria standard. Il type Ordering è

un’altra enum e ha le varianti Less, Greater e Equal. Questi sono i tre

risultati possibili quando si confrontano due valori.

Poi aggiungiamo cinque nuove righe in basso che utilizzano il type Ordering.

Il metodo cmp confronta due valori e può essere richiamato su qualsiasi cosa

possa essere confrontata. Come parametro prende un reference a qualsiasi cosa

si voglia confrontare: in questo caso sta confrontando ipotesi con

numero_segreto. Poi restituisce una variante dell’enum Ordering che

abbiamo portato nello scope con l’istruzione use. Utilizziamo un’espressione

match per decidere cosa fare successivamente in base a

quale variante di Ordering è stata restituita dalla chiamata a cmp con i

valori in ipotesi e numero_segreto.

Un’espressione match è composta da due rami. Da una parte un pattern su

cui fare il confronto, dall’altra il codice da eseguire se il valore dato a

match corrisponde al pattern. Rust prende il valore dato a match e lo

confronta con il _ pattern_ dei vari rami, eseguendo poi il codice se

corrispondono. I pattern e il costrutto match sono potenti caratteristiche

di Rust: ti permettono di esprimere una varietà di situazioni in cui il tuo

codice potrebbe imbattersi e ti assicurano di gestirle tutte. Queste

caratteristiche saranno trattate in dettaglio nel Capitolo 6 e nel Capitolo 19,

rispettivamente.

Facciamo un esempio con l’espressione match che utilizziamo qui. Supponiamo

che l’utente abbia ipotizzato 50 e che il numero segreto generato in modo

casuale questa volta sia 38.

Quando il codice confronta 50 con 38, il metodo cmp restituirà

Ordering::Greater perché 50 è maggiore di 38. L’espressione match ottiene il

valore Ordering::Greater e inizia a controllare il pattern di ciascun ramo.

Esamina il pattern del primo ramo, Ordering::Less, e vede che il valore

Ordering::Greater non corrisponde a Ordering::Less, quindi ignora il codice

in quel ramo e passa al ramo successivo. Il modello del ramo successivo è

Ordering::Greater, che corrisponde a Ordering::Greater! Il codice

associato in quel ramo verrà eseguito e stamperà Troppo grande! sullo schermo.

L’espressione match termina dopo la prima corrispondenza riuscita, quindi non

esaminerà l’ultimo ramo in questo scenario.

Tuttavia, il codice del Listato 2-4 non viene compilato. Proviamo:

$ cargo build

Compiling libc v0.2.86

Compiling getrandom v0.2.2

Compiling cfg-if v1.0.0

Compiling ppv-lite86 v0.2.10

Compiling rand_core v0.6.2

Compiling rand_chacha v0.3.0

Compiling rand v0.8.5

Compiling gioco_indovinello v0.1.0 (file:///progetti/gioco_indovinello)

error[E0308]: mismatched types

--> src/main.rs:23:21

|

23 | match guess.cmp(&numero_segreto) {

| --- ^^^^^^^^^^^^^^ expected `&String`, found `&{integer}`

| |

| arguments to this method are incorrect

|

= note: expected reference `&String`

found reference `&{integer}`

note: method defined here

--> /rustc/4eb161250e340c8f48f66e2b929ef4a5bed7c181/library/core/src/cmp.rs:964:8

For more information about this error, try `rustc --explain E0308`.

error: could not compile `gioco_indovinello` (bin "gioco_indovinello") due to 1 previous error

Il messaggio di errore afferma che ci sono mismatched types (type non

corrispondenti). Rust ha un sistema di type forte e statico. Tuttavia, ha

anche l’inferenza del type. Quando abbiamo scritto let mut ipotesi = String::new(), Rust è stato in grado di dedurre che ipotesi doveva essere un

String e non ci ha fatto scrivere il type. Il numero_segreto, d’altra

parte, è un type numerico. Alcuni type numerici di Rust possono avere un

valore compreso tra 1 e 100: i32, un numero a 32 bit; u32, un numero a 32

bit senza segno; i64, un numero a 64 bit; e altri ancora. Se non diversamente

specificato, Rust imposta come predefinito un i32, che è il type di

numero_segreto a meno che non si aggiungano informazioni sul type altrove

che indurrebbero Rust a dedurre un type numerico differente. Il motivo

dell’errore è che Rust non può confrontare una type stringa e un type

numerico.

In definitiva, vogliamo convertire la String che il programma legge come input

in un type numerico in modo da poterlo confrontare numericamente con il numero

segreto. Lo facciamo aggiungendo questa riga al corpo della funzione main:

File: src/main.rs

use std::cmp::Ordering;

use std::io;

use rand::Rng;

fn main() {

println!("Indovina il numero!");

let numero_segreto = rand::thread_rng().gen_range(1..=100);

println!("Il numero segreto è: {numero_segreto}");

println!("Inserisci la tua ipotesi.");

// --taglio--

let mut ipotesi = String::new();

io::stdin()

.read_line(&mut ipotesi)

.expect("Errore di lettura");

let ipotesi: u32 = ipotesi.trim().parse().expect("Inserisci un numero!");

println!("Hai ipotizzato: {ipotesi}");

match ipotesi.cmp(&numero_segreto) {

Ordering::Less => println!("Troppo piccolo!"),

Ordering::Greater => println!("Troppo grande!"),

Ordering::Equal => println!("Hai indovinato!"),

}

}La riga è:

let ipotesi: u32 = ipotesi.trim().parse().expect("Inserisci un numero!");Creiamo una variabile di nome ipotesi. Ma aspetta, il programma non ha già una

variabile di nome ipotesi? Sì, ma Rust ci permette di oscurare, il valore

precedente di ipotesi con uno nuovo. Lo Shadowing ci permette di

riutilizzare il nome della variabile ipotesi invece di costringerci a creare

due variabili uniche, come ipotesi_str e ipotesi, per esempio. Ne parleremo

in modo più dettagliato nel Capitolo 3, ma per ora,

sappi che questa funzione è spesso usata quando vuoi convertire un valore da un

type ad un altro.

Leghiamo questa nuova variabile all’espressione ipotesi.trim().parse().

L’ipotesi nell’espressione si riferisce alla variabile ipotesi originale che

contiene l’input come stringa. Il metodo trim su un’istanza di String

elimina ogni spazio bianco ad inizio e fine, cosa da fare prima di convertire la

stringa in u32, che può contenere solo dati numerici. L’utente deve premere

invio per confermare l’input da terminale e questo aggiunge un

carattere nuova_linea (newline d’ora in poi) alla stringa letta da

read_line. Per esempio, se l’utente digita 5 e poi preme

invio, ipotesi conterrà: 5\n. Il carattere \n rappresenta

newline. (Su Windows, premere invio aggiunge anche il carattere di

ritorno a capo oltre a newline, risultando in \r\n.) Il metodo trim

elimina sia \n che \r\n, restituendo quindi solo 5.

Il metodo parse sulle stringhe converte una stringa in

un altro type. In questo caso, lo usiamo per convertire una stringa in un

numero. Dobbiamo indicare a Rust il tipo esatto di numero che vogliamo usando

let ipotesi: u32. I due punti (:) dopo ipotesi dicono a Rust che

annoteremo il tipo di variabile. Rust ha alcuni type numerici incorporati;

u32 visto qui è un intero a 32 bit senza segno. È una buona scelta predefinita

per un piccolo numero positivo. Imparerai a conoscere altri type numerici

Capitolo 3.

Inoltre, l’annotazione u32 in questo programma di esempio e il confronto con

numero_segreto significa che Rust dedurrà che anche numero_segreto dovrebbe

essere un u32. Quindi ora il confronto sarà tra due valori con lo stesso

type!

Il metodo parse funziona solo su caratteri che possono essere convertiti

logicamente in numeri e quindi può facilmente causare errori. Se, ad esempio, la

stringa contenesse A👍%, non ci sarebbe modo di convertirla in un numero.

Poiché potrebbe fallire, il metodo parse restituisce un type Result,

proprio come fa il metodo read_line (discusso in precedenza in “Gestire i

Potenziali Errori con Result”). Tratteremo questo Result allo stesso modo utilizzando nuovamente

il metodo expect. Se parse restituisce una variante Err perché non è

riuscito a creare un numero dalla stringa, la chiamata expect causerà il crash

del gioco e stamperà il messaggio che gli abbiamo fornito. Se parse riesce a

convertire la stringa in un numero, restituirà la variante Ok di Result e

expect restituirà il numero che vogliamo dal valore Ok.

Ora eseguiamo il programma:

$ cargo run

Compiling gioco_indovinello v0.1.0 (file:///progetti/gioco_indovinello)

Finished `dev` profile [unoptimized + debuginfo] target(s) in 0.26s

Running `target/debug/gioco_indovinello`

Indovina il numero!

Il numero segreto è: 58

Inserisci la tua ipotesi.

76

Hai ipotizzato: 76

Troppo grande!

Bene! Anche se sono stati aggiunti degli spazi prima del numero, il programma ha capito che l’utente aveva ipotizzato 76. Esegui il programma alcune volte per verificare il diverso comportamento con diversi tipi di input: ipotizzare il numero corretto, ipotizzare un numero troppo alto e ipotizzare un numero troppo basso.

Ora la maggior parte del gioco funziona, ma l’utente può fare una sola ipotesi. Cambiamo questa situazione aggiungendo un ciclo!

Consentire Più Ipotesi con la Ripetizione